Nous savions déjà qu’une IA était en mesure de falsifier seule des photos ou des vidéos. Si les algorithmes sont capables de nous berner de la sorte, ils ne sont pas eux-mêmes prémunis contre ce risque. Et pour tromper les calculs d’une intelligence artificielle, la technique pourrait tenir en un mot : des autocollants.

Dans un document publié le 27 décembre 2017, plusieurs ingénieurs de Google mettent en évidence les incidences d’ « images contradictoires » sur l’intelligence artificielle. Tom B. Brown, Dandelion Mané, Aurko Roy, Martín Abadi et Justin Gilmer expliquent comment ces autocollants parviennent à tromper les algorithmes.

Autrement dit, imaginez une sorte d’illusion optique capable de se jouer des calculs d’une IA, et que vous pourriez coller sur un objet comme une simple étiquette.

Universel, robustes et ciblés

« Les autocollants sont universels, car ils peuvent être utilisés pour attaquer n’importe quel décor, ils sont robustes, car ils fonctionnent malgré une grande variété de transformations, et ils sont ciblés, car ils peuvent brouiller les classes cibles de n’importe quel classificateur », écrivent les chercheurs.

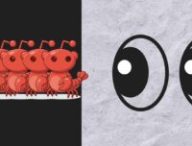

Ils ajoutent que ces images, une fois imprimées, peuvent être collées sur n’importe quel objet. Même si les corrections apportées à l’image sont infimes, elles troublent les algorithmes qui se mettent alors à ignorer le reste de la scène. Ainsi, un autocollant perturbe, dans la vidéo ci-dessus, une IA qui croit voir un grille-pain à la place d’une banane.

D’ailleurs, les ingénieurs ajoutent que vous pourriez tout à fait reproduire cette démonstration chez vous, en imprimant simplement l’image suivante avant de la coller sur les objets de votre choix.

Les chercheurs de Google notent qu’un tel sticker pourrait permettre à des « assaillants de créer une attaque physique, sans reconnaissance préalable des conditions d’éclairage, de l’angle de la caméra, du type de classificateur attaqué ou même des autres éléments de la scène. »

On comprend donc qu’une telle manœuvre puisse susciter quelques inquiétudes, si l’on anticipe un éventuel usage malveillant dans le domaine de la conduite autonome. Outre les épineuses questions posées par ces véhicules, il faudrait aussi envisager la présence de telles images sur la route, qui pourraient fausser les choix de l’IA.

« Une attaque physique, sans reconnaissance préalable »

Malgré tout, les ingénieurs de Google tempèrent cette prédiction alarmiste : en dépit de l’efficacité étonnante de ces stickers, il ne faut pas non plus leur attribuer trop de pouvoir. Les « images contradictoires » ne sont pas une recette magique, qui fonctionnerait à tous les coups sur n’importe quelle intelligence artificielle.

Néanmoins, ce travail de recherche souligne leur potentiel et la flexibilité qui pourraient caractériser de futures attaques ciblant les failles des calculs algorithmiques.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !