L’intelligence artificielle ne se cantonne plus aux interfaces virtuelles. Google DeepMind a présenté le 26 septembre 2025 deux nouveaux modèles d’IA conçus pour piloter des robots. Leur particularité ? Les modèles Gemini Robotics 1.5 et Gemini Robotics-ER 1.5 sont capables de collaborer pour donner naissance aux premiers robots capables de « penser » avant d’agir. Et puisqu’une bonne nouvelle n’arrive jamais seule, Gemini Robotics-ER 1.5 est aussi le premier modèle de robotique Gemini accessible à tous les développeurs, dès aujourd’hui en avant-première via l’API Gemini dans Google AI Studio.

Donner de « l’intelligence » à des robots

L’entreprise avait annoncé en mars dernier le lancement de Gemini Robotics et Gemini Robotics-ER, deux modèles conçus pour donner de « l’intelligence » à des robots. Il s’agissait déjà d’une étape marquante, notamment en raison de la transposition de la compréhension multimodale de Gemini dans le monde physique. Gemini Robotics n’est pas un simple logiciel de contrôle : c’est le cerveau du robot.

Le modèle reçoit des images des caméras du robot et des instructions en langage naturel (« prends la tasse bleue et range-la dans l’étagère »), analyse la scène, planifie les étapes, puis génère directement les commandes de mouvement à envoyer aux moteurs. La version 1.5 renforce ainsi cette boucle perception-raisonnement-action avec plusieurs nouveautés :

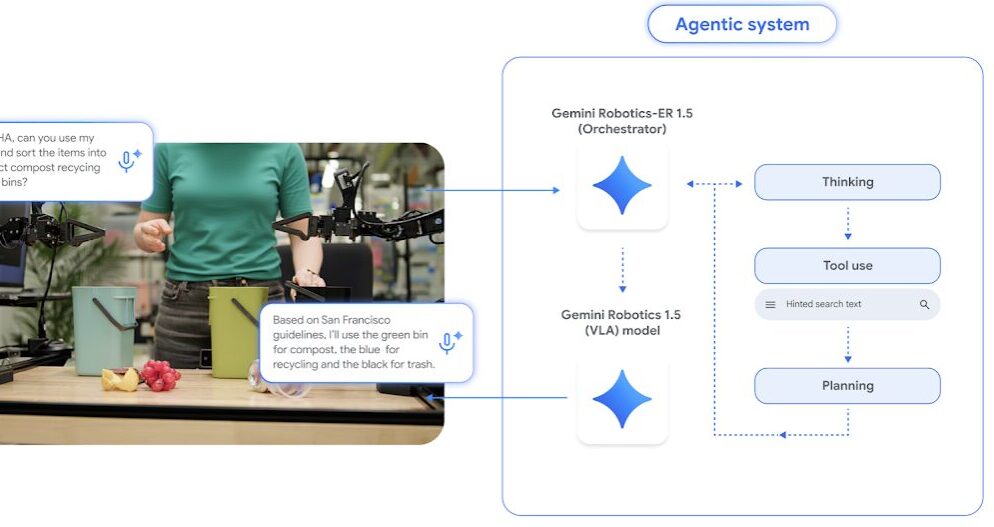

- Gemini Robotics 1.5 : Ce modèle « vision-langage-action » (VLA) transforme des images et des instructions en véritables commandes motrices, afin que le robot exécute une tâche. Il est capable de raisonner avant d’agir et d’exposer ses étapes de réflexion, ce qui lui permet d’aborder des missions complexes avec plus de transparence. Il apprend aussi d’un robot à l’autre, ce qui accélère l’acquisition de nouvelles compétences.

- Gemini Robotics-ER 1.5 : Ce modèle, qui est un « VLM », pour « vision-language model », analyse l’environnement physique, appelle nativement directement des outils numériques et élabore des plans précis en plusieurs étapes pour accomplir une mission. Selon Google, il atteint désormais un niveau record dans les tests de compréhension et de raisonnement spatial.

Un robot capable de trier ses déchets ?

Comme l’explique Google DeepMind dans son billet de blog, « la plupart des tâches quotidiennes nécessitent des informations contextuelles et plusieurs étapes à réaliser », ce qui les rend particulièrement difficiles pour nos robots d’aujourd’hui. L’entreprise prend l’exemple d’un robot à qui l’on demanderait, en fonction de notre localisation, de « trier ces objets et les placer dans les bacs de compost, de recyclage et de poubelle appropriés ». Cela impliquerait notamment que le robot recherche les consignes de recyclage de la ville en question sur Internet, observe les objets devant lui et détermine comment les trier selon ces règles.

Ces nouveaux modèles apportent au robot tout le chaînon manquant entre l’instruction et l’action :

- Compréhension du contexte : Gemini Robotics-ER 1.5 peut aller chercher les règles de tri propres à la ville sur Internet, puis raisonner sur la scène qu’il voit.

- Planification en plusieurs étapes : il élabore un plan (identifier les objets, choisir le bon bac, vérifier l’espace disponible, etc.) et surveille la progression. Le modèle ER génère ensuite des instructions en langage naturel, c’est-à-dire des étapes précises que le robot doit suivre pour accomplir la tâche.

- Exécution précise : Gemini Robotics 1.5, le modèle d’action, traduit ces consignes en gestes concrets (saisir, déplacer, déposer). Il utilise son propre processus de réflexion pour déterminer comment il va appréhender chaque étape.

En combinant raisonnement, recherche d’informations et génération directe de mouvements, le robot pourrait ainsi trier correctement même dans un environnement inconnu ou changeant.

Autre avancée notable, Gemini Robotics 1.5 serait capable de transférer les mouvements appris à travers les incarnations. Normalement, un robot doit repartir de zéro à chaque nouvelle plateforme : chaque bras, chaque capteur, chaque moteur nécessite de réentrainer le modèle. Ici, un mouvement appris sur un robot peut être réutilisé tel quel sur un autre, sans spécialisation préalable.

Google explique que « les tâches présentées uniquement au robot ALOHA 2 » lors de l’entraînement fonctionnent également sur le robot humanoïde d’Apptronik, Apollo, et sur le robot bi-bras Franka (et vice versa).

Cette transférabilité peut réduire considérablement le temps d’entraînement et accélère l’adoption de nouveaux comportements, rendant les robots plus intelligents et rapidement opérationnels.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !