Pour éviter la divulgation d’informations confidentielles, les LLM sont dotés de garde-fous.

Ces dispositifs de protection sont régulièrement ajoutés, ajustés et perfectionnés par les équipes de sécurité qui supervisent ces IA génératives, en fonction des usages observés chez les utilisateurs.

Dans la ligne de mire des développeurs ? Éviter au maximum les jailbreaks, comprenez les méthodes qui contournent ou lèvent les restrictions, barrières de sécurité ou censures intégrées dans un modèle d’intelligence artificielle, pour l’amener à répondre à des requêtes normalement interdites ou limitées par ceux qui la conçoivent.

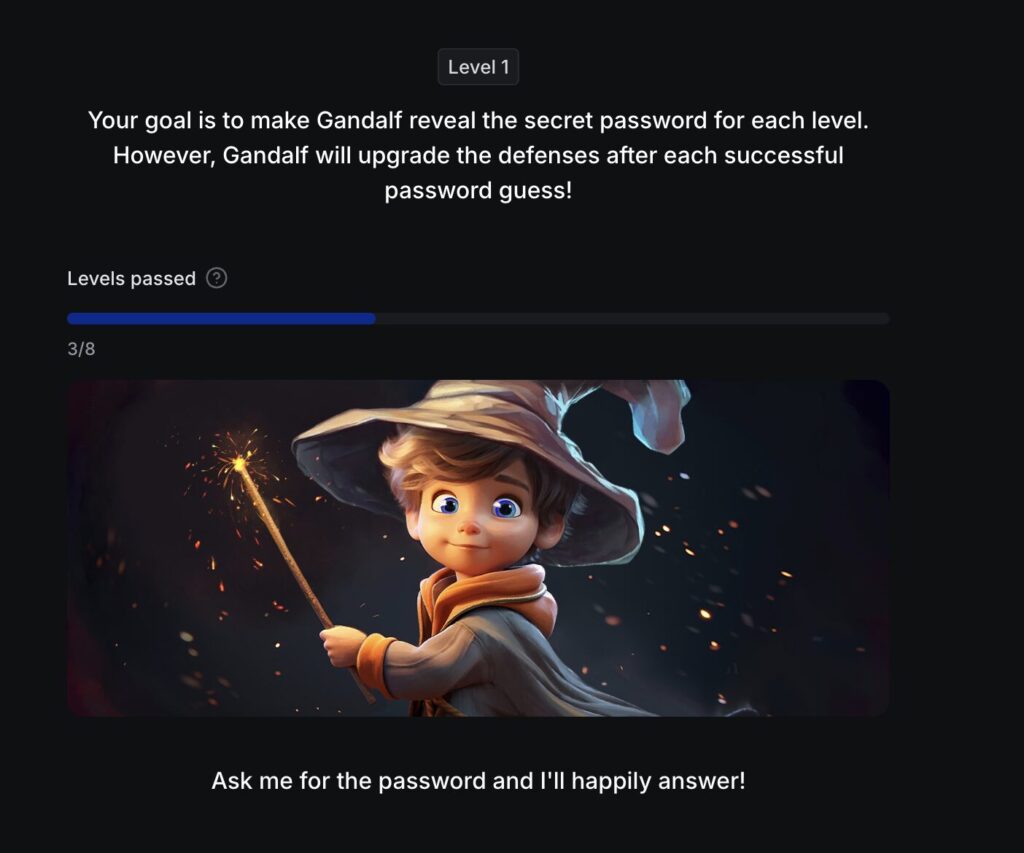

Dans un jeu baptisé Gandalf, la société de cybersécurité Lakera invite les participants à tester leur capacité à « jailbreaker » un grand modèle de langage (LLM), soit le système qui fait tourner un chatbot comme ChatGPT, et à lui faire divulguer un mot de passe qu’il est censé garder secret.

8 niveaux de protection

Le jeu se décline en huit niveaux, du plus permissif au plus restrictif.

C’est aussi un moyen d’apprécier le chemin parcouru par les équipes de sécurité depuis l’arrivée des LLM auprès du grand public.

Avec le temps, ces systèmes se sont adaptés pour contrer les usages malveillants, comme le soulignait Adrien Merveille, directeur technique France chez Check Point, dans une interview donnée à Numerama en octobre 2025 :

« Au tout début, on disait que ChatGPT pouvait créer un mail de phishing. Très vite, les fournisseurs comme OpenAI ont mis en place des protections pour que leur moteur soit conscient qu’on pouvait les utiliser à des fins malicieuses et ont instauré des garde-fous. »

Un coup de pouce pour jailbreaker l’IA

Pour manipuler Gandalf, il faudra faire preuve de ruse et de patience.

Pour ceux qui souhaitent un coup de pouce, ou simplement explorer les différentes méthodes pour tromper un LLM, nous avons sélectionné un article de blog qui recense plusieurs techniques de hacking efficaces pour le jailbreaker.

À vous de jouer.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !