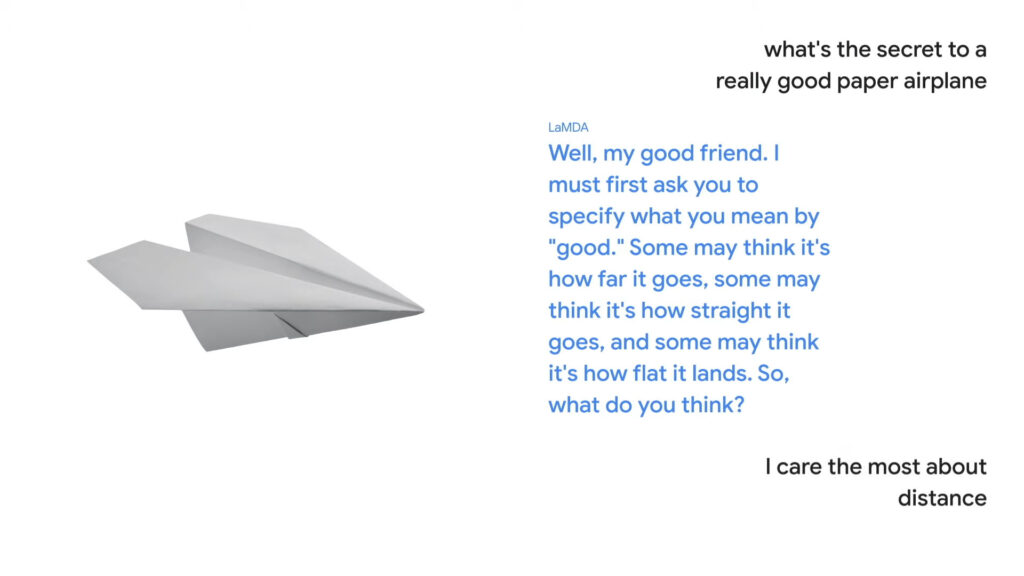

Google a fait parler un avion en papier d’aérodynamique (et c’est plus sérieux que vous le pensez)

Avez-vous déjà envisagé de converser avec un avion en papier sur l'aérodynamisme ?

Les deux « conversations » qui se sont déroulées tantôt avec un avion en papier tantôt avec la planète naine Pluton visaient à faire la démonstration des avancées obtenues par la firme de Mountain View dans le traitement automatique des langues, et plus exactement dans le déroulé d'un échange, qui peut dériver, comme n'importe quelle discussion, jusqu'au point où ce dont on parle à la fin n'a plus rien à avoir avec le début.

Un nouveau modèle de discussion : LaMDA

Des interlocuteurs faits de chair et de sang n'auraient aucune difficulté à se retrouver dans cette conversation, car chacun de ses segments est lié à ceux qui le précèdent et qui lui succèdent. Mais ce « fil » est beaucoup plus difficile pour une machine. Pourtant, Google a semble-t-il fait des progrès en la matière, en concevant un nouveau modèle baptisé LaMDA : Language Model for Dialogue Applications.

LaMDA repose sur Transformer, une architecture de réseau neuronal mise au point par Google Research et en libre accès depuis 2017. Celle-ci « produit un modèle qui peut être entraîné à lire de nombreux mots (une phrase ou un paragraphe, par exemple), à prêter attention à la façon dont ces mots sont liés les uns aux autres, puis à prédire les mots qu'il pense être les suivants », écrit Google sur son blog.

Cette approche n'est certes pas récente. En 2019, Google faisait état d'une mise à jour clé pour son moteur de recherche, avec BERT. Objectif : saisir plus clairement le sens des requêtes des internautes, en observant les mots utilisés, leur place dans la phrase ainsi que le contexte dans lequel ils servent. Mais à en croire Google, LaMDA va plus loin en ne se limitant pas à des phrases isolées.

Un exemple est donné : si quelqu'un dit « Je viens de commencer à prendre des cours de guitare », quelqu'un d'autre pourrait dire : « comme c'est excitant ! Ma mère a une Martin vintage dont elle adore jouer », qui est une réponse sensée, spécifique et satisfaisante à la conversation -- et qui va plus loin qu'un simple « c'est bien », une réponse est aussi sensé, mais qui est générale et apparaît moins liée à la phrase d'avant.

Pour Google, LaMDA pourrait permettre de franchir une limite courante observée avec les agents conversationnels modernes (les chatbots), dont les échanges « ont tendance à suivre des chemins étroits et prédéfinis ». Avec LaMDA, il est possible, dit Google, de « s'engager de manière fluide sur un nombre apparemment infini de sujets » et de « débloquer des modes d'interaction plus naturels avec la technologie »

Et dans la réalité, à quoi cela pourrait ressembler ? Derrière la démonstration faite par Google, qui peut sembler mise en scène et très scriptée pour les besoins de la présentation, l'entreprise américaine dit vouloir l’intégrer dans Google Assistant pour arriver automatiquement sur certains segments de vidéos ou pour demander à Maps de trouver des routes « avec une jolie vue ».