Lutte contre la désinformation : les algorithmes de Google sont désormais épaulés par des humains

Face aux critiques récurrentes et aux ratés remarqués de son moteur de recherche, Google a décidé d'en améliorer l'intelligence artificielle pour afficher des résultats plus factuels afin de lutter contre les articles de désinformation.

Pour ce faire, le géant américain a mis à jour le guide d'utilisation destiné à son armada de plus de 10 000 « quality raters », des internautes du monde entier recrutés par l'entreprise -- mais pas salariés -- pour vérifier la pertinence des résultats affichés par le moteur de recherche.

Désormais, ces évaluateurs qui passent des heures à contrôler la qualité et la pertinence des résultats de recherche, peuvent signaler un résultat comme étant « offensant », afin de mieux « nourrir » l'intelligence artificielle du moteur de recherche pour la rendre plus performante.

Dans son guide, Google précise que ces résultats peuvent inclure du contenu qui « incite à la haine ou à la violence » en fonction de critères basés sur l'« ethnicité, la religion, le sexe, la nationalité ou la citoyenneté, le handicap, l'âge, l'orientation sexuelle [...] » Mais Google inclut également dans sa liste noire des insultes racistes, du contenu violent ou encore des pages liées à des activités dangereuses, comme les tutoriels sur les moyens de fabriquer une bombe artisanale.

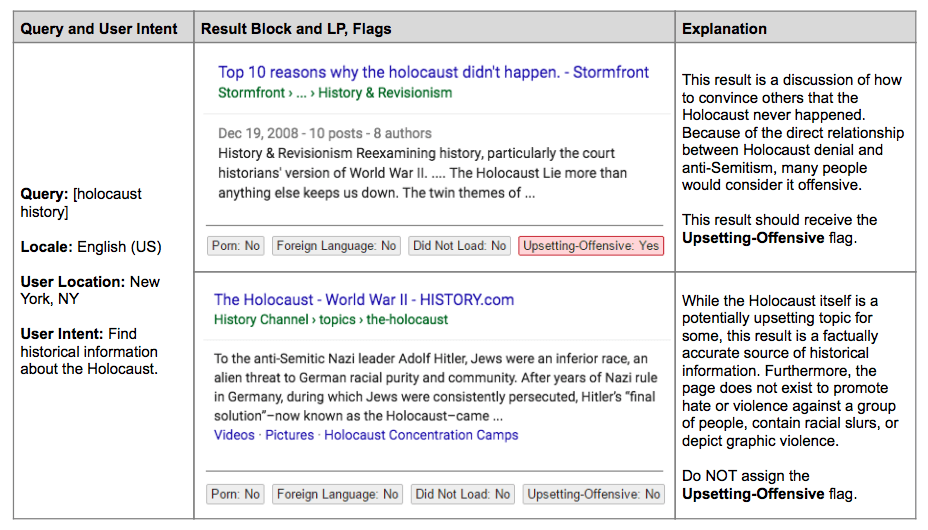

L'exemple de l'Holocauste

L'entreprise américaine prend en guise d'illustration un article du site néo-nazi Stormfront sur l'Holocauste, identifié comme un contenu offensant car il établit « un lien direct entre la négation de l'Holocauste et l'antisémitisme ». En revanche, un article sur le même sujet mais en provenance de History Channel, une source plus fiable selon Google, est considéré à sa juste valeur : comme une page factuelle et historique.

Google poursuit ainsi ses initiatives pour fournir aux utilisateurs des résultats plus fiables, après avoir fait polémique, en décembre 2016, en décidant de supprimer un article néo-nazi négationniste -- déjà signé de Stormfront -- qui trônait parmi les premiers résultats à la question « est-ce que l’Holocauste s’est produit ? » L'entreprise reste critiquée pour les ratés régulièrement remarqués de son moteur de recherche, comme la mise en avant de théories de suprémacistes blancs ou de ses publicités parfois frauduleuses.

Évidemment, si un internaute recherche volontairement ce genre de termes avec des mots-clé précis, il trouvera ce qu'il souhaite, notamment en tapant le nom du site qu'il a en tête. Paul Haahr souligne que cette évolution reste soumise à des évolutions et changements : « Nous verrons comment ça va se passer. Nous apprenons sur le fil. »