Ces IA imitent les humains dans un village virtuel créé avec ChatGPT

Les intelligences artificielles qui nous imitent, c'est déjà le présent.

Si vous mettez plusieurs intelligences artificielles de ce type dans un village virtuel, que se passerait-il ? C'est justement l'objet de cette expérience, dont les résultats ont été mis en ligne le 10 avril 2023 sur la plateforme arxiv (ce n'est donc pas encore une étude publiée dans une revue ni relue par des pairs). Les auteurs voulaient mettre à l'épreuve des « simulations crédibles du comportement humain ».

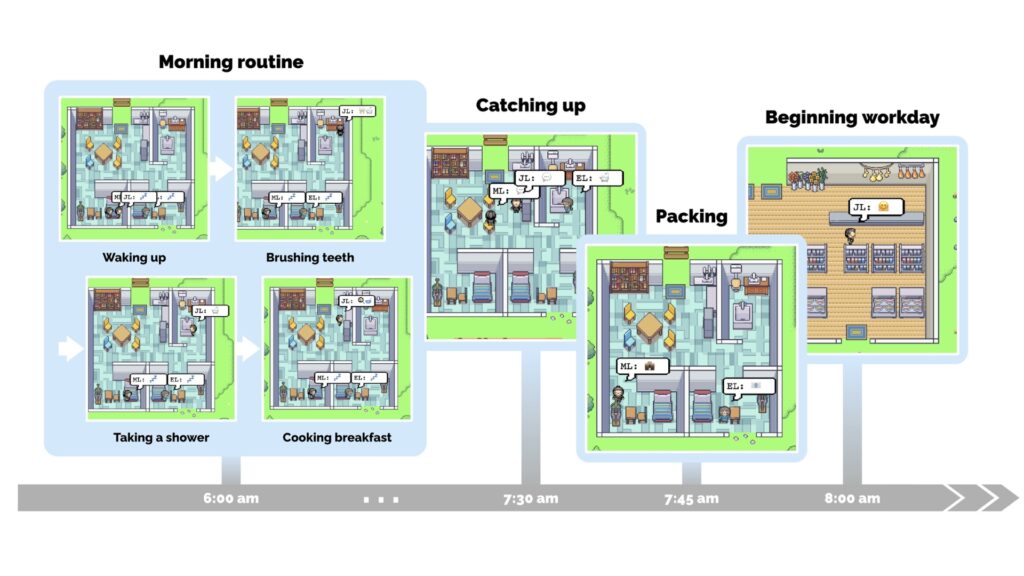

Ils ont donc mis en place un environnement interactif « de type bac à sable inspiré des Sims », baptisé Smallville. Le replay de l'expérience, sous forme de démo, peut être visionné en ligne.

On y trouve 25 personnages, qui correspondent chacun à une instance créée dans ChatGPT. Plusieurs familles vivent dans ce village et chaque membre a sa petite vie, qui ressemble à celle d'un humain. Dans la famille Lin, par exemple, John -- qui se présente comme un pharmacien -- « est le premier à se réveiller à 7 heures. Il se brosse les dents, prend une douche, s'habille, prend son petit-déjeuner et consulte les news sur la table à manger », décrivent les chercheurs.

Bienvenue à Smallville, village peuplé d'IA

Les personnages étaient invités à générer des actions en fonction du moment et des circonstances. Par exemple, lorsque les chercheurs indiquent qu'il est 7 heures du matin, c'est là que John Lin se brosse les dents, embrasse sa femme, s'habille et se rend à la cuisine. C'est aussi le cas de son fils Eddy. En recevant ses propres informations, il s'est aussi levé pour se brosser les dents et se rendre dans la cuisine.

Les IA sont amenées à communiquer entre elles. C'est ce qui peut donner des conversations à l'aspect fortement crédible :

John: Good morning Eddy. Did you sleep well?

Eddy: Good morning dad. Yeah, I slept great.

John: That’s good. What are you working on today?

Eddy: I’m working on a new music composition for my class. It’s due this week, so I’m trying to get it finished. But I’m having so much fun with it!

John: That sounds great!

Tout au long de la fausse journée de Smalville, ces échanges d'informations à chaque interaction sont gardés en mémoire par chaque IA et produisent des comportements adaptés. Par exemple, quand un personnage apprend la candidature de tel autre personnage au poste de maire, il est amené à en parler avec un troisième protagoniste en simulant ce que l'on pourrait dire sur un tel sujet :

Isabella: I’m still weighing my options, but I’ve been discussing the election with Sam Moore. What are your thoughts on him?

Tom: To be honest, I don’t like Sam Moore. I think he’s out of touch with the community and doesn’t have our best interests at heart.

En interagissant les uns avec les autres, les agents génératifs ont ainsi des comportements sociaux « émergents plutôt que préprogrammés », écrivent les auteurs dans leur papier de recherche. Cela signifie que le prompt initial (la requête venant de l'humain) de chaque IA ne livre qu'un contexte qui va être amené à évoluer, ce à quoi chaque IA saura dynamiquement répondre. Ce qui ressemble à une discussion est en réalité une succession de prompts imprévus livrant des données. « Lorsque les agents se remarquent les uns les autres, ils peuvent engager un dialogue -- ce faisant, l'information peut se propager d'un agent à l'autre », expliquent les auteurs.

C'est une performance impressionnante pour une IA comme ChatGPT. Ce chatbot n'a pas été conçu pour imiter sur le long terme des personnages de fiction, ou pour spéculer sur les détails les plus anodins de la journée d'une personne, mais elle démontre sa capacité à imiter certains comportements humains. Cela provient d'une modification du modèle LLM (Logic learning machine) qui, chez ces IA, disposent aussi d'une mémoire et d'une capacité de planification, ce qui permet de tenir un « rôle » cohérent au long terme. C'est une nouvelle architecture dans le design même de ces IA, qui incorpore la réponse dynamique à des circonstances changeantes.

On remarquera que la « vie » simulée, chez ces Sims, semble particulièrement douce : les IA sont focalisées sur les bonnes attitudes à avoir, sans aucun sentiment négatif chez ces personnages. Peut-on vraiment réduire le comportement humain à cela ?

Les risques de l'anthropomorphisme

L'étude ne vient pas sans une discussion éthique proposée par ses auteurs. Ces derniers adressent tout particulièrement le risque d'anthropomorphisme -- par exemple, en ayant la sensation que tel personnage exprime de réelles émotions humaines. Ils invitent, dans la conception même de ce type d'IA, « à atténuer le risque que les utilisateurs nouent des relations parasociales ».

Cet anthropomorphisme n'est en effet jamais bien loin. Avant que ChatGPT ne fasse l'actualité, on se souvient de l'ingénieur de Google, Blake Lemoine, qui avait déclaré que l'IA sur laquelle il travaillait était aussi « consciente » que ses collègues.