ChatGPT impressionne comme bijou technologique et fait la Une de l’actualité depuis plusieurs mois maintenant. Mais, derrière ce succès, se cache une face bien moins reluisante. Une vaste enquête du magazine TIME, publiée le 18 janvier 2023, révèle comment OpenAI, la société créatrice du programme, a mobilisé, via un sous-traitant, des travailleurs kényans rémunérés 2 dollars de l’heure. Dans des conditions de travail, qui plus est, traumatisantes.

Si OpenAI a fait appel à ces travailleurs, c’est pour rendre ChatGPT moins « toxique », c’est-à-dire éviter qu’il puisse vous répondre des textes racistes, homophobes, violents. Leur rôle était de modérer, en amont, ce risque. Mais à quel prix ?

Des données provenant « des recoins les plus sombres d’Internet » pour modérer ChatGPT

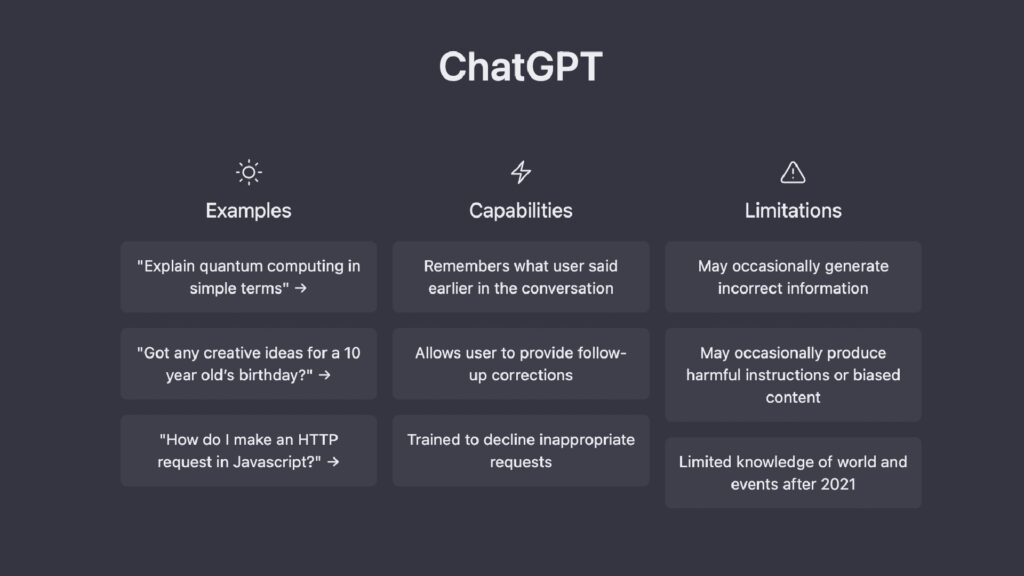

Si l’intelligence artificielle de ChatGPT se distingue, c’est grâce au modèle GPT-3.5. Basé sur un réseau de neurones artificiels, il contient des centaines de millions de paramètres. Son entraînement est si performant que, prenant la forme d’un chatbot avec lequel on peut converser, il répond efficacement à une multitude de questions, dans un langage souvent assez naturel. Le programme est conçu comme une interface servicielle, pour accéder aux demandes des utilisateurs et des utilisatrices.

Mais, pour en arriver là, GPT-3 a été entraîné à partir de données massives extraites… d’Internet. Pour le meilleur et pour le pire : le web n’est pas toujours un endroit très sain et l’humanité n’y révèle pas toujours son meilleur jour. Résultat, GPT-3 avait initialement intégré des biais racistes, sexistes, homophobes. L’algorithme pouvait fournir, à une époque, des réponses violentes et discriminantes. Il est apparemment toutefois difficile, à ce stade, pour OpenAI, d’éliminer ces données toxiques préalables de la base de données. C’est donc en aval, plutôt qu’en amont, que l’entreprise a mis en place un mécanisme pour limiter la toxicité de son algorithme.

Le système de sécurité développé par OpenAI consiste à ajouter un filtre à ChatGPT, en lui apprenant à repérer et à labelliser les contenus problématiques. En clair, ChatGPT est exposé à ces biais d’origine, mais est censé pouvoir les « bloquer » en amont pour qu’ils n’arrivent pas à l’utilisateur. C’est, en partie, ce que font certains réseaux sociaux, comme Facebook.

Comme le relate le TIME, OpenAI a fait appel à une entreprise de sous-traitance baptisée Sama. Très mobilisée dans la Silicon Valley, celle-ci est spécialisée dans la labellisation de données sensibles et emploie de personnes au Kenya, en Inde, en Ouganda. Pour les labels de ChatGPT, les travailleurs avaient en charge d’être face à des dizaines de milliers de bribes de texte provenant « des recoins les plus sombres d’Internet ». Parmi ces contenus, aux descriptions très graphiques, on trouvait « abus sexuels sur des enfants, la zoophilie, le meurtre, le suicide, la torture, l’automutilation et l’inceste ».

« C’était une torture »

OpenAI et Sama ont passé trois contrats d’une valeur totale de 200 000 dollars. Dans son pôle au Kenya, l’entreprise a construit trois groupes, d’une douzaine de personnes chacun, se répartissant trois thèmes principaux : abus sexuels, discours de haine, violence. Ces employés étaient payés entre 1,32 et 2 dollars de l’heure pour cette labellisation. Ils devaient analyser environ 150 à 250 bribes de texte, de 100 à 1 000 mots par bride, par journée de neuf heures.

Quatre employés, au témoignage anonymisé, racontent au TIME un travail d’une nature traumatisante. Un homme explique au magazine que la description graphique d’une certaine scène, particulièrement atroce, l’a mené à souffrir de cauchemars récurrents durablement. « C’était une torture », décrit-il. Les employés avaient accès à des thérapeutes « bien-être » pour les aider ; mais ces séances étaient « rares », étaient limitées à des sessions en groupe et ne compensaient pas l’exigence de productivité par ailleurs. Un témoin indique même qu’il s’est vu refuser plusieurs fois un entretien individuel avec l’un de ces thérapeutes.

Sama a nié en partie les accusations de ces témoignages auprès du TIME. L’entreprise indique de son côté que les séances thérapeutiques étaient individualisées et pouvaient être réclamées à tout moment ; que le nombre de textes à labelliser était de 70 par jour et non de 150 à 250 ; et que le salaire allait de 1,46 à 3,74 dollars de l’heure.

Malgré tout, l’enquête du TIME révèle que la « nature traumatisante du travail » a finalement conduit Sama à mettre fin à sa collaboration OpenAI en février 2022, « huit mois plus tôt que prévu ».

« Une étape nécessaire pour réduire la quantité de contenus violents et sexuels » selon OpenAI

OpenAI a également fourni une réponse de son côté, confirmant d’abord avoir fait appel à Sama pour rendre ChatGPT moins toxique : « (…) Nous travaillons dur pour construire des systèmes d’IA sûrs et utiles qui limitent les préjugés et les contenus préjudiciables ». Selon le porte-parole, « la classification et le filtrage des [textes et images] préjudiciables constituent une étape nécessaire pour réduire la quantité de contenus violents et sexuels inclus dans les données d’entraînement et créer des outils capables de détecter les contenus préjudiciables ». Quant aux conditions de travail, OpenAI dit ne pas avoir indiqué d’objectifs de productivité et que tout le management relevait de Sama en tant que sous-traitant.

OpenAI ajoute : « Nous prenons très au sérieux la santé mentale de nos employés et celle de nos contractants. Nous avions cru comprendre que [chez Sama] des programmes de bien-être et des conseils individualisés étaient proposés, que les travailleurs pouvaient refuser certaines tâches sans être pénalisés, que l’exposition à des contenus explicites était limitée et que les informations sensibles étaient traitées par des travailleurs spécifiquement formés à cet effet. »

Le TIME met par ailleurs en exergue la difficulté des employés de Sama à labelliser certains contenus ambigus. L’enquête dans son ensemble pointe donc la manière donnt l’enjeu des biais toxiques, au sein des IA, issus des données massives incorporées, pose de sérieux problèmes pour les gérer.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Si vous avez aimé cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à Numerama sur Google News.