Terrorisme : le gouvernement s'attaque aux bulles filtrantes de Facebook, Youtube,...

Le gouvernement a dévoilé lundi 9 mai un nouveau plan d'action (.pdf) contre la radicalisation et le terrorisme, avec une série de 80 mesures destinées à mieux détecter en amont les potentiels terroristes, surveiller les filières, prévenir la radicalisation, développer des contre-discours, ou encore mieux sécuriser les sites sensibles. À ce titre, comme le remarque Pixels, le gouvernement a annoncé différentes mesures qui touchent directement à Internet, régulièrement considéré comme le principal terreau du terrorisme, sur lequel poussent les nouvelles recrues. La mesure la plus concrète pour les internautes ne relève pourtant pas des compétences directes du gouvernement, mais plutôt des accords négociés avec les acteurs privés du Web.

L'enfermement algorithmique, qu'est-ce que c'est ?

Le problème de l'enfermement algorithmique est identifié de longue date (sous l'expression anglophone de « bubble filter » ou « bulle filtrante »), et ne concerne pas seulement la radicalisation conduisant au terrorisme, mais plus largement toutes les opinions politiques, les connaissances culturelles ou même la diversité commerciale.

Sur les réseaux sociaux et sur les moteurs de recherche qui personnalisent les fils d'actualités ou les résultats, les algorithmes recommandent les contenus ou les personnes qui sont les plus susceptibles de plaire à l'internaute, en fonction de ses propres centres d'intérêts, ou de ceux de ses contacts. Ceux qui pensent la même chose ont donc tendance à être recommandés les uns aux autres, à se recommander des contenus entre eux, et donc à nourrir de plus en plus les thèses de leur propre extrémisme.

Les ultra libéraux parleront avec des partisans de la mort de l'État et partageront des articles qui montrent les ravages du socialisme, alors que les trostkistes débattront entre eux des nouveaux rapports sur la croissance des inégalités et de la corruption des élites. Chaque communauté de pensée se trouve donc isolée avec elle-même, dans un système intellectuel asphyxiant, où les pensées « adverses » ne sont même plus visibles.

L'activiste Eli Pariser avait popularisé le concept dans un livre et dans une conférence Ted :

https://www.youtube.com/watch?v=B8ofWFx525s

Ré-oxygéner les bulles filtrantes djihadistes

Le problème est évidemment d'une gravité particulière s'agissant des discours sectaires, en particulier ceux qui conduisent à s'intéresser de plus en plus aux thèses radicales de cercles djihadistes, et à ne plus voir que celles-ci, à force de recommandations qui entraînent des recommandations supplémentaires. Regarder sur YouTube quelques vidéos d'un imam autoproclamé, ou de démonstrations plus ou moins fantaisistes de théories du complot, c'est l'assurance de se faire recommander d'autres vidéos du même genre, toujours plus radicales à mesure que l'on avance dans un couloir qui ne montre plus ce qu'il y a autour.

D'où le souhait du gouvernement, qui dans le cadre de son plan d'action demande aux « acteurs économiques concernés » de « prendre en compte d’autres facteurs dans leurs mécanismes techniques de recommandation, comme par exemple les signalements et éventuels retraits passés de contenus similaires ».

« La visualisation préalable d’un contenu vu ou aimé conduit mécaniquement à ce que la personne concernée s’en voit proposer 10 de nature similaire, puis 10 autres, jusqu’à ce que l’offre présentée à l’utilisateur soit parfois entièrement consacrée à ces contenus de haine. Ce phénomène d’enfermement algorithmique ne peut être combattu que par les acteurs économiques concernés », assure le gouvernement.

Une coopération avec les acteurs privés

À ce titre, le gouvernement indique qu'il a « entamé un dialogue stratégique et technique avec les principaux acteurs concernés afin de parvenir à circonscrire ce phénomène ». Cette discussion s'inscrit dans un plan plus global de coopération entre les géants du Web et l'État français, impulsé après les attentats de janvier 2015 contre Charlie Hebdo et l'épicerie juive de la porte de Vincennes, et intensifiés après ceux de novembre 2015 contre différents points de Paris, dont le Bataclan.

Pour la première fois, le gouvernement énonce explicitement la possibilité d'une « recommandation de contre-discours dans l’offre de contenus », c'est-à-dire une mise en avant de contenus produits par l'État ou par des partenaires privés. Il est toutefois peu probable (et certainement peu souhaitable) que les géants comme Facebook ou Google acceptent de modifier leurs algorithmes pour rendre artificiellement plus visibles des contenus de contre-propagande.

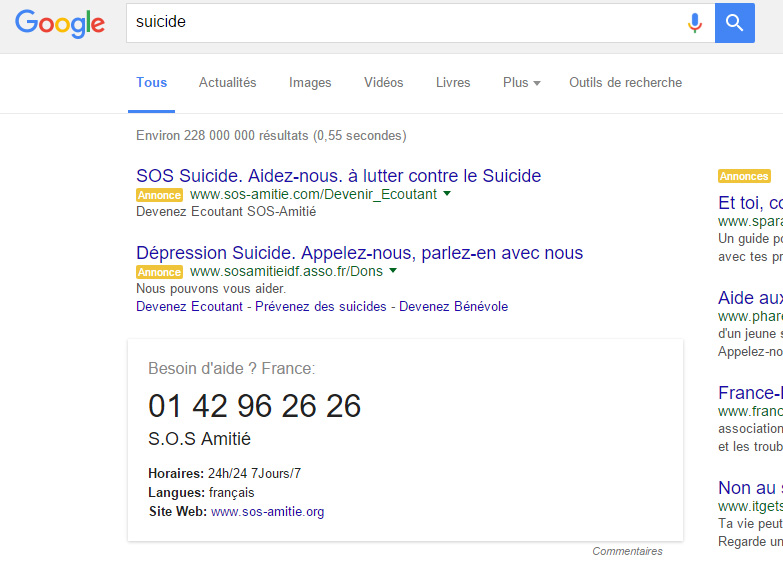

Mais en Grande-Bretagne, Google a déjà annoncé des modifications qui vont dans le même sens. « Nous allons lancer deux programmes pilotes. L’un pour s’assurer que ce type de vidéos (de contre-propagande) se trouve plus facilement sur YouTube. L’autre pour s’assurer que lorsque les gens recherchent des termes qui peuvent causer préjudice dans notre moteur de recherche, ils trouvent aussi ce contre-discours », avait annoncé en début d'année Anthony House, le directeur des relations publiques de Google. Il s'agirait toutefois davantage d'afficher des encarts de prévention, à l'instar de ce que les internautes suicidaires peuvent trouver :

On espèrera toutefois que le « contre-discours » proposé sera d'une autre efficacité que le compte Twitter officiel @StopDjihadisme, dont nous avions montré le caractère très caricatural, qui ne lui permet pas d'avoir une véritable portée. L'État en est d'ailleurs conscient puisqu'il souhaite financer une fondation de droit privé pour que les contre-propagandes puissent être portées par des acteurs privés, perçus comme plus légitimes.