Derrière tous les mots vidés de leur sens qui lui sont souvent attribués, l’intelligence artificielle pourrait être décrite comme un sac d’algorithmes, entrainés pour prendre des décisions (a priori) rationnelles. Dans ce contexte, la question de la responsabilité de celles et ceux qui enrichissent lesdits algorithmes est donc essentielle.

Or, la présence de biais dans des résultats donnés par une intelligence artificielle questionne directement nos propres préjugés — voilà qui n’est pas très flatteur pour notre ego. En septembre 2016, un concours de beauté jugé par des algorithmes avait montré ce phénomène : la majorité des gagnants choisis par l’IA étaient des personnes à la peau claire.

Les IA peuvent reproduire nos propres préjugés

En avril dernier, un autre travail de recherche a mis en avant la persistance de stéréotypes racistes et sexistes dans des intelligences artificielles chargées de travailler sur le langage.

Les biais fondés sur le genre ou l’apparence des individus dans les calculs menés par des intelligences artificielles suscitent de plus en plus l’intérêt des chercheurs. C’est le cas de Timnit Gebru, étudiante en doctorat au Standford Artificial Intelligence Laboratory et chercheuse postdoctorale au sein du groupe FATE (Fairness Transparency Accountability and Ethics in AI) de Microsoft Research.

Constatant que ses propres travaux sur l’intelligence artificielle contenaient des préjugés, elle s’est investie dans ce programme mis au point il y a trois ans par Microsoft, dont l’objectif est de traquer les biais qui viennent perturber les calculs des IA — y compris dans sa propre thèse.

En 2011, Microsoft, IBM et l’université de Toronto avaient déjà unis leurs forces dans une étude qui identifiait la nécessité de prévenir les discriminations reproduites par les algorithmes.

Des inconnues laissées dans les IA

Ace Kamar, une autre chercheuse de Microsoft Research spécialisée dans l’intelligence artificielle (membre pour sa part du Human-Computer Interaction) a cherché à éliminer les biais en ciblant les zones d’ombres dans les données analysées par les algorithmes.

La chercheuse mène ces travaux en compagnie d’Himabindu Lakkaraju, étudiante en doctorat d’informatique à l’université de Standford et membre du groupe Adoptive System and Interaction de Microsoft Research.

Des « inconnues inconnues »

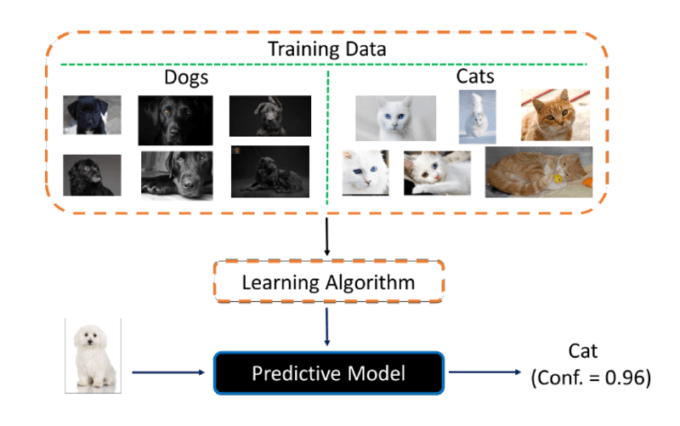

Ensemble, elles se sont interrogées sur les données que les IA analysent, en partant du postulat que les ingénieurs y laissent parfois des « inconnues inconnues » (ou des genres de trous noirs, si vous préférez). Elles ont programmé une intelligence artificielle pour qu’elle soit en mesure de différencier des chats et des chiens, de couleur brune ou blanche.

L’intelligence artificielle n’a pas seulement donné de faux résultats ; en étiquetant une image de chien blanc comme celle d’un chat, ses algorithmes ont surtout estimé que leur résultat était fiable. L’image suivante permet de mieux comprendre l’erreur de l’IA, et pourquoi celle-ci croyait avoir raison.

Dit autrement, c’est un peu comme si l’IA avait une confiance trop importante dans ses propres calculs. Les deux chercheuses ont alors voulu trouver d’où venait cet excès de confiance, avant de modifier le fonctionnement des algorithmes.

Si ces différentes recherches témoignent d’une volonté de supprimer certains biais présents dans les IA, il faudrait certainement des années pour les éradiquer à l’aide d’une méthode fiable. À supposer que l’on parvienne à lire correctement dans le cerveau de silicone des intelligences artificielles, qui deviennent parfois de véritables boîtes noires à force d’apprendre.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Si vous avez aimé cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à Numerama sur Google News.