Même si nous lisons des livres et assistons à des cours à l'école, nos connaissances sont avant tout dictées par la reproduction des gestes et du langage. Personne ne nous enseigne à mettre un pied devant l'autre pour marcher, à fermer la main pour saisir une fourchette, ou à dire "zut" (ou autre chose) lorsque l'on fait une bêtise. C'est en voyant les autres faire que ces choses semblent devenir instinctives. Or c'est cette capacité à apprendre par soi-même que les roboticiens tentent aujourd'hui de développer avec le concours des spécialistes de l'intelligence artificielle, qui mettent au point des technologies d'auto-apprentissage de plus en plus proches du fonctionnement du cerveau humain (y compris certains processeurs spécialisés).

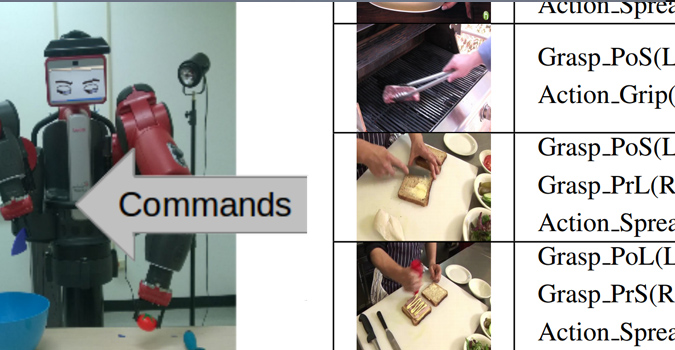

Des chercheurs de l'Université du Maryland et du NICTA australien viennent ainsi de publier une étude (.pdf) dans laquelle ils expliquent avoir appris à des robots comment cuisiner, en leur faisant regarder des vidéos sur YouTube. L'objectif de l'étude était que le robot sache reconnaître les gestes employés et les ingrédients utilisés, qu'il formule lui-même les associations correspondantes dans un langage syntaxique, qu'il pourrait réutiliser pour reproduire les actions. Par exemple l'IA génère d'elle-même la fonction Action_Spread (Spreader,Bread) lorsqu'elle comprend qu'il faut utiliser le couteau à beurre pour étaler quelque chose sur une tranche de pain.

Bien sûr la réalité est moins flatteuse pour l'IA, puisqu'il a d'abord fallu que les chercheurs traitent manuellement une grande quantité des plans des 88 vidéos utilisées, pour renseigner une base de données de départ sur le type d'outils utilisés (couteau, fourchette, batteur, cuillère…), d'aliments ou de gestes employés. Ces métadonnées associées aux portions d'images correspondantes sont ensuite ingérées par deux modules basés sur des réseaux de neurones à convolution, l'un dédié à la reconnaissance des mouvements de saisie d'objets par la main, et l'autre à la reconnaissance des objets et ingrédients (c'est le même type de technologie que celle utilisée par Google pour légender des photos). Le but de l'expérience est alors de vérifier si le robot est capable de reconnaître les objets et les actions sur des images qui n'ont pas été traitées manuellement, en utilisant le savoir accumulé.

Selon les résultats publiés qui couvrent uniquement 10 % de l'échantillon retenu, l'intelligence artificielle a réussi à reconnaître le type de geste utilisé dans 77 % des cas, et à reconnaître les aliments ou objets dans 93 % des cas. 83 % des actions sont bien reconnues. Les chercheurs estiment que ces résultats démontrent une "haute précision" de l'apprentissage par YouTube, d'autant plus remarquable qu'il s'agit ici de reconnaître des mouvements sans l'aide d'informations 3D, et dans des situations réelles qui ne permettent pas toujours de bien voir quel objet est dans la main, ou quelle est la forme de la main autour d'un objet.

L'étude ne dit pas, en revanche, si les chercheurs ont réellement demandé à un robot de réaliser une omelette, et s'ils l'ont goûtée. Mais ce sera certainement l'objet d'une nouvelle publication, et une mauvaise nouvelle de plus pour les cuisiniers McDo. Et bien sûr, ce qui est possible pour la cuisine le sera dans beaucoup d'autres domaines.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Abonnez-vous à Numerama sur Google News pour ne manquer aucune info !